O que é Privacy Preservating Machine Learning (PPML)

A inteligência artificial passa a integrar o cotidiano das pessoas, torna-se imprescindível desenvolver, simultaneamente, novas abordagens da privacidade.

A proteção da privacidade é um direito essencial de todo ser humano e o avanço da AI se faz necessário para novas descobertas. Como equilibrar este cabo de guerra?

Neste artigo, vamos falar de Privacy Preserving Machine Learning (PPML) com foco em proteger dados ao treinar grandes modelos de linguagem, o termo é uma iniciativa da Microsoft. Outras organizações do setor — como IBM e Amazon Web Services — adotam termos semelhantes, como privacy-preserving ML, privacy-enhancing ML, federated learning for privacy para descrever esforços de proteção de dados distribuídos e aprendizagem colaborativa.

O que é Privacy-Preserving Machine Learning (PPML)

É o conjunto de técnicas e práticas de IA voltadas a proteger os dados pessoais durante o treinamento e a operação de modelos de aprendizado de máquina.

Em vez de simplesmente “analisar tudo”, o PPML busca extrair inteligência sem expor ou transferir dados sensíveis.

Isso é especialmente relevante em IoT, onde dados vêm de sensores espalhados — em casas, veículos, hospitais, fazendas — e não podem ser centralizados sem risco.

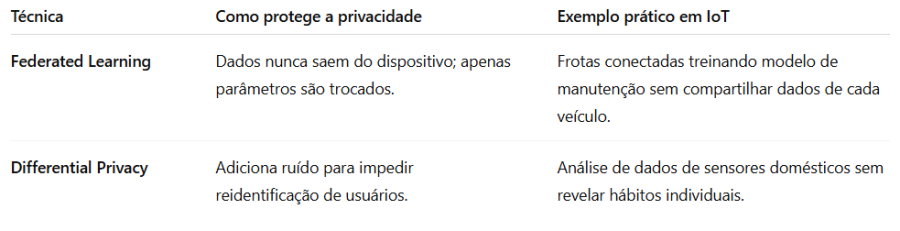

Principais técnicas e o seu funcionamento

1. Federated Learning (Aprendizado Federado)

Em vez de enviar todos os dados para um servidor central, cada dispositivo (ou empresa, ou hospital, por exemplo) treina o modelo localmente com seus próprios dados.

O que é compartilhado com o servidor central não são os dados, mas os parâmetros (pesos) do modelo aprendidos localmente.

Como acontece na prática:

Um modelo inicial é distribuído para vários dispositivos/servidores locais.

Cada nó treina esse modelo com seus próprios dados (que nunca saem dali).

Apenas os ajustes (gradientes ou pesos) são enviados ao servidor central.

O servidor agrega essas atualizações e cria um modelo global mais inteligente.

Exemplo:

Um sistema de diagnóstico médico que aprende a partir de vários hospitais — sem que nenhum paciente tenha seus dados enviados para fora da instituição.

Benefícios:

- Protege privacidade (dados nunca saem da origem).

- Reduz custo de transferência de dados.

- Permite colaboração entre entidades concorrentes (ex.: operadoras, bancos, hospitais).

Desafios:

- Requer sincronização complexa entre dispositivos.

- Pode sofrer ataques se as atualizações forem maliciosas (há soluções criptográficas para isso).

2. Differential Privacy (Privacidade Diferencial)

É uma técnica matemática que insere ruído controlado nos dados ou nos resultados de um modelo, de modo que não seja possível identificar uma pessoa específica mesmo que se tenha acesso ao banco ou às saídas do modelo.

Como funciona:

Antes de armazenar ou compartilhar dados, adiciona-se uma pequena quantidade de ruído aleatório (ex.: pequenas variações em idades, localização ou valores).

O modelo aprende com o conjunto agregado, mas ninguém consegue “reconstruir” o dado original individual.

Exemplo:

Ao analisar dados de mobilidade urbana, o sistema adiciona ruído às coordenadas geográficas de usuários. As tendências de trânsito são detectadas, mas nenhuma rota pessoal é revelada.

Benefícios:

- Garante anonimato matemático.

- Pode ser certificado (NIST, Google, Apple usam differential privacy).

Desafios:

É preciso calibrar bem o ruído: demais → reduz precisão; de menos → reduz privacidade.

Por que isso importa no contexto da Internet das Coisas

Em IoT, há muitos dados sensíveis distribuídos: sensores domésticos, wearables, máquinas industriais, dados ambientais, etc.

Centralizar tudo em um servidor gera riscos legais (LGPD) e técnicos (ataques, vazamentos).

O PPML resolve isso:

- Garante aprendizado distribuído seguro (federated learning).

- Assegura proteção de identidade e dados pessoais (differential privacy).

- Facilita conformidade com legislações de privacidade como LGPD e GDPR.

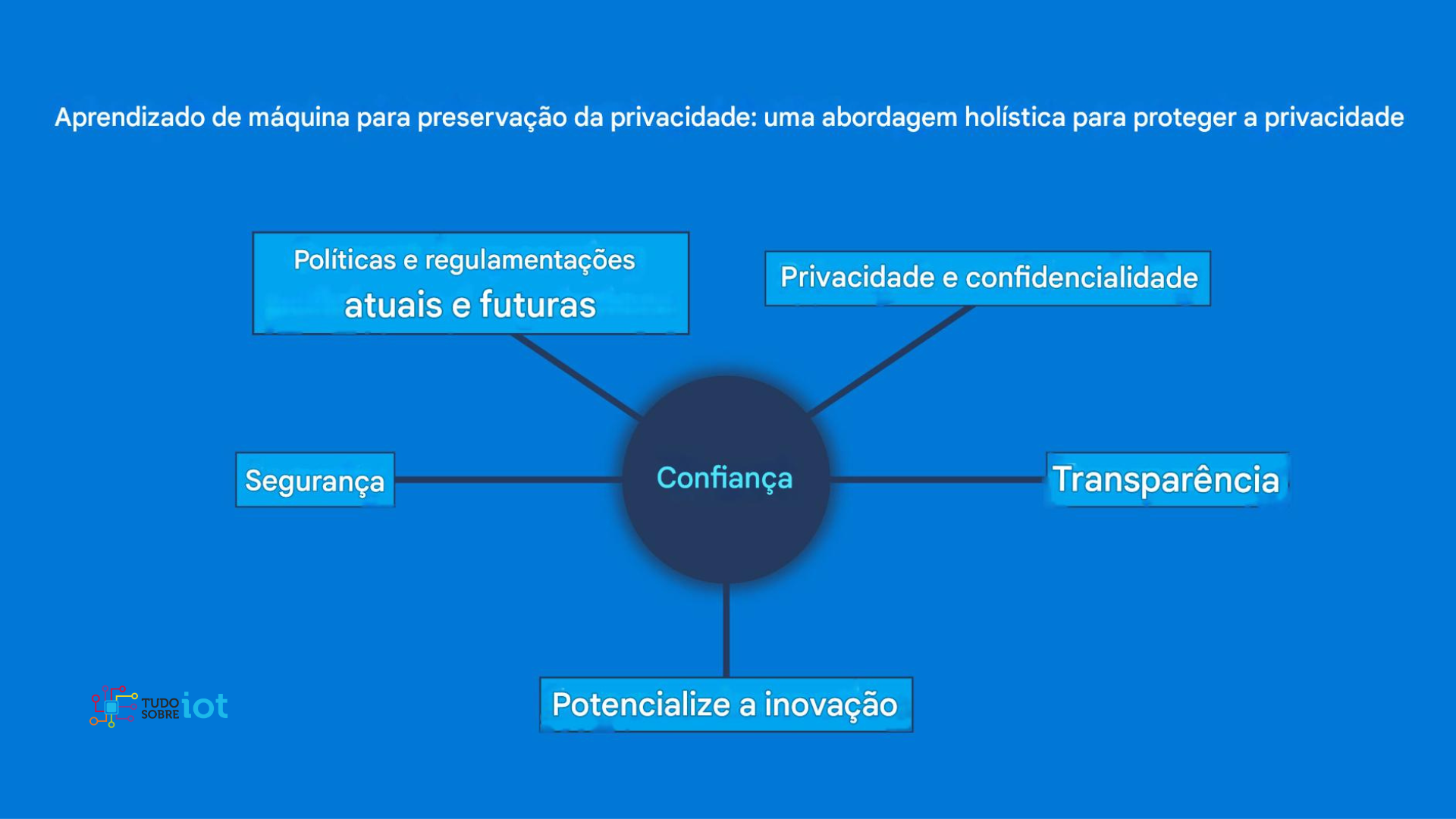

- Aumenta a confiança do usuário — essencial para a adoção de IoT em massa.

Resumo

Privacidade-preserving ML é o uso de técnicas que permitem treinar modelos de inteligência artificial sem expor dados sensíveis. O federated learning treina o modelo localmente — os dados não saem do dispositivo —, e a differential privacy adiciona ruído matemático para impedir a reidentificação de pessoas. São práticas essenciais para a IoT, onde a segurança e a confiança são tão importantes quanto a inovação.

Matérias relacionadas

Insights do Mendix Transform 2025: Inteligência, Agilidade e Ética para o Futuro Digital

Mendix Transform 2025, o maior evento de IA e low-code da América Latina, realizado pela Siemens na ARCA, em São Paulo.

Em 31/10/2025 às 16h17 - Atualizado em 31/10/2025 às 16h40

Inteligência Artificial Inexplicável: O impacto nas empresas e na sociedade

O resultado frustrante dos sucessos recentes da IA é que as pessoas não conseguem fornecer explicações para muitas das decisões tomadas por esses sistemas.

Em 24/04/2023 às 18h52 - Atualizado em 25/04/2023 às 14h22

Insights do Mendix Transform 2025: Inteligência, Agilidade e Ética para o Futuro Digital

Mendix Transform 2025, o maior evento de IA e low-code da América Latina, realizado pela Siemens na ARCA, em São Paulo.

Em 31/10/2025 às 16h17 - Atualizado em 31/10/2025 às 16h40

Inteligência Artificial Inexplicável: O impacto nas empresas e na sociedade

O resultado frustrante dos sucessos recentes da IA é que as pessoas não conseguem fornecer explicações para muitas das decisões tomadas por esses sistemas.

Em 24/04/2023 às 18h52 - Atualizado em 25/04/2023 às 14h22